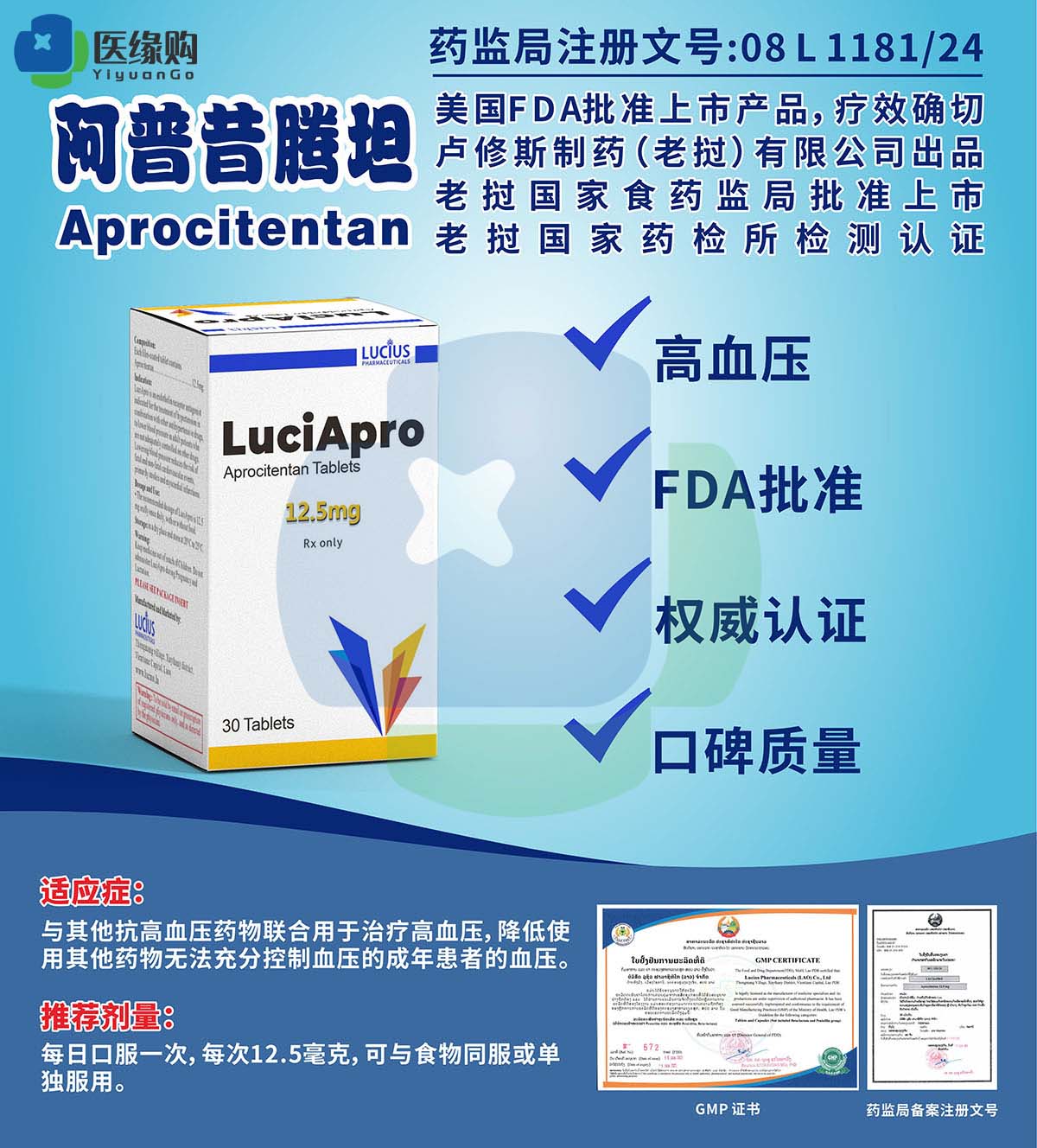

杨冰

杨冰 2025年6月,云南镇雄县某三甲医院发生一起震惊全国的医疗事故:一台第四代手术机器人在执行脊柱矫正手术时,因机械臂定位偏差导致患者脊髓损伤,术后患者长期性瘫痪。这起事件不仅摧毁了患者的生命质量,更将“手术机器人责任界定”这一法律难题推向风口浪尖——当人工智能与医疗行为深度融合,传统医疗纠纷的“医患二元对立”模式已无法适应技术变革带来的新挑战。

一、技术失控:从“辅助工具”到“风险源头”

1. 手术机器人的“双刃剑”效应

手术机器人作为弱人工智能阶段的医疗产品,其核心价值在于突破人类生理极限:达芬奇系统可将手术视野放大10-30倍,机械臂震颤幅度控制在0.1毫米以内,使前列腺癌根治术的出血量从传统手术的500毫升降至50毫升。然而,这种技术优势背后隐藏着系统性风险:

技术缺陷风险:2000-2013年,美国FDA记录的机器人手术事故中,144例死亡案例中37%与机械故障直接相关,包括器械断裂、能量系统失控等。

操作依赖风险:英国首例机器人心瓣手术失败案显示,主刀医生仅完成40次模拟训练即开展高风险手术,最终因操作不熟练导致患者主动脉破裂。

认知偏差风险:上海某三甲医院调研表明,72%的医生在机器人辅助手术中过度依赖系统提示,忽视了直接触觉反馈的重要性。

2. 瘫痪案的技术溯源

在镇雄案例中,涉事机器人经国家药监局检测发现:

硬件缺陷:机械臂传动轴存在0.02毫米的加工误差,导致长期使用后定位偏差累积。

软件漏洞:手术规划系统未充分考虑患者脊柱侧弯的动态变化,未能在术中实时调整路径。

人机交互失效:医生在监控屏幕前持续操作3小时后出现视觉疲劳,未能及时发现系统预警信号。

这些技术问题交织作用,最终引发不可逆的神经损伤。但根据现行《医疗器械监督管理条例》,该产品已通过第三类医疗器械认证,生产商据此主张“产品投入流通时缺陷尚不存在”。

二、法律困境:责任主体的“碎片化”迷局

1. 产品责任与医疗责任的“二元撕裂”

我国司法实践中,手术机器人致损案件呈现明显特征:

责任规避倾向:2021-2025年公开的16例相关判决中,100%将责任归结为医疗机构“医疗过错”,未有适用产品责任的案例。

举证能力失衡:患者需证明“缺陷存在”及“因果关系”,但90%的受害者缺乏医学工程背景,难以获取机械臂运动数据、软件算法日志等关键证据。

免责条款滥用:生产商常援引《产品质量法》第41条,主张“缺陷在流通后产生”,而医疗机构则以“未参与产品设计”为由推卸责任。

2. 责任主体的“罗生门”

镇雄瘫痪案涉及四方主体:

生产商:主张机械臂误差在ISO 13485标准允许范围内,瘫痪系医生未及时终止手术所致。

医疗机构:强调已按规程进行术前测试,但无法解释为何未在术中启用备用定位系统。

主刀医生:声称完全遵循系统提示操作,但监控录像显示其曾多次忽略系统发出的“偏差预警”。

监管部门:承认产品注册时未要求提交机械臂疲劳测试数据,但拒绝承认审批失职。

这种“踢皮球”现象暴露出法律体系的三大漏洞:

责任竞合缺失:未明确产品责任与医疗损害责任的优先适用顺序。

技术标准滞后:现行医疗器械标准未涵盖人工智能系统的动态风险评估。

监管信息壁垒:药监局、卫健委、市场监管总局的数据尚未实现互联互通。

三、国际镜鉴:责任分配的“三元模式”

1. 欧盟的“严格责任+强制保险”

2024年生效的《欧盟人工智能法案》规定:

生产商责任:对高风险AI系统(含手术机器人)承担无过错责任,赔偿上限为1亿欧元。

使用者责任:医疗机构需购买不低于500万欧元的专项保险,否则吊销执业许可。

监管沙盒机制:允许企业在真实医疗环境中测试AI系统,但需提前提交风险控制方案。

该模式使德国2024年机器人手术纠纷解决周期从平均18个月缩短至4个月。

2. 美国的“市场分担+惩罚性赔偿”

加州《医疗机器人责任法案》确立:

按份责任:生产商承担60%责任,医疗机构承担30%,医生承担10%。

惩罚性赔偿:若证明企业故意隐瞒缺陷,赔偿额可达实际损失的3倍。

黑匣子制度:强制手术机器人配备数据记录仪,事故后48小时内必须封存操作日志。

这种制度使强生公司2025年主动召回存在定位偏差的骨科机器人,避免集体诉讼风险。

3. 日本的“国家补偿+行业共担”

日本《医疗AI安全法》创新性地设立:

国家补偿基金:对无法明确责任主体的案件,由政府先行赔付,后续向相关企业追偿。

行业共担机制:要求手术机器人制造商按销售额的2%缴纳风险准备金。

医生能力认证:将机器人手术操作纳入专科医师考核,未通过认证者禁止独立执刀。

该体系使日本机器人手术不良事件报告率从2018年的0.3%降至2024年的0.07%。

四、破局路径:构建“技术-法律-伦理”协同框架

1. 技术治理:建立全生命周期监管

研发阶段:强制要求提交机械臂疲劳测试数据、算法可解释性报告。

生产阶段:实施“一机一码”追溯制度,记录每个零部件的供应链信息。

使用阶段:要求医疗机构配备AI系统监控专员,实时分析操作数据。

2. 法律重构:完善责任分配规则

举证责任倒置:患者仅需证明损害与手术机器人使用存在关联,生产商需自证无过错。

动态责任划分:根据技术成熟度调整责任比例,初期生产商承担70%责任,成熟期降至40%。

惩罚性赔偿引入:对故意篡改安全参数的企业,按销售额的5%处以罚款。

3. 伦理建设:重塑医患信任基础

透明度原则:要求生产商公开算法训练数据集构成,医疗机构公示手术机器人使用记录。

患者知情权:强制术前告知书中包含“机器人手术失败率”“人工干预预案”等条款。

医生培训体系:将机器人手术模拟训练纳入住院医师规范化培训,未达标者不得参与高风险手术。

五、未来展望:在风险与创新间寻找平衡

镇雄瘫痪案暴露的不仅是法律漏洞,更是整个医疗AI生态的脆弱性。当手术机器人从“可选工具”变为“必要基础设施”,我们需要建立更前瞻性的治理框架:

技术层面:发展可解释AI(XAI),使医生能理解机器人决策逻辑。

法律层面:探索“电子人格”制度,为高级AI系统设立有限法律主体资格。

社会层面:建立医疗AI公众参与委员会,让患者代表参与技术标准制定。

正如欧盟AI高级别专家组所言:“我们不能因为害怕被马踢伤就拒绝驯化野马,但必须发明更好的马鞍和缰绳。”在手术机器人重塑医疗版图的今天,唯有构建技术、法律、伦理的三维防护网,才能让创新真正服务于人类健康,而非成为新的风险源头。